Si vous développez des applications avec des LLMs, vous avez sûrement passé du temps à peaufiner vos prompts. Mais aujourd’hui, ça ne suffit plus. Bienvenue dans l’ère du context engineering.

Le prompt engineering a ses limites

Un bon prompt, c’est bien. Mais imaginez un agent qui doit coder pendant des heures, consulter des dizaines de fichiers, et se souvenir de ce qu’il a fait il y a 200 étapes. Votre prompt initial ne va pas tenir la route longtemps.

Le problème, c’est que les fenêtres de contexte sont limitées et coûteuses. Vous ne pouvez pas tout balancer dedans. Et même si vous pouviez, ce serait contre-productif : noyer le modèle sous l’info, c’est le meilleur moyen d’obtenir des réponses médiocres.

Les agents modernes ont besoin de plus : gérer dynamiquement l’information, savoir quoi garder en mémoire, quoi aller chercher, et quand. C’est là qu’intervient le context engineering.

Context engineering : de quoi on parle ?

Le context engineering, c’est tout ce qui concerne la gestion du contexte fourni à un modèle pendant son exécution. Pas juste au début, mais tout au long du processus.

Ça couvre trois aspects principaux. D’abord, la sélection : quelle info mettre dans le contexte à chaque étape ? Ensuite, la structuration : comment organiser cette info pour que le modèle la comprenne efficacement ? Enfin, la gestion dynamique : comment faire évoluer le contexte au fil du temps ?

Contrairement au prompt engineering qui se concentre sur la formulation de l’instruction, le context engineering s’occupe de l’écosystème informationnel complet de votre agent.

Pourquoi c’est crucial pour les agents

Un agent sans bon context engineering, c’est un dev qui bosse sans historique git, sans documentation, et avec une mémoire de poisson rouge. Il va répéter les mêmes erreurs, oublier ses décisions précédentes, et chercher des infos qu’il a déjà trouvées.

Avec un context engineering solide, votre agent maintient une mémoire de travail cohérente. Il sait ce qu’il a fait, pourquoi il l’a fait, et peut accéder aux ressources pertinentes au bon moment. La différence de performance est spectaculaire.

C’est encore plus important pour les systèmes multi-agents où chacun doit non seulement gérer son propre contexte, mais aussi communiquer efficacement avec les autres.

Context engineering et RAG

Les systèmes RAG (Retrieval-Augmented Generation) sont probablement l’exemple le plus concret de context engineering en action. Le principe : aller chercher l’info pertinente dans une grosse base de données avant de générer une réponse.

Mais c’est plus subtil qu’il n’y paraît. Vous devez décider comment découper vos documents (le chunking), comment les indexer, quelle stratégie de recherche utiliser (sémantique, par mots-clés, hybride), comment re-ranker les résultats, et comment assembler le contexte final.

Chaque décision impacte directement la qualité des réponses. Un chunking mal fait et vous perdez du contexte important. Un re-ranking absent et vous envoyez des infos non pertinentes. Un assemblage brouillon et le modèle ne comprend pas ce que vous lui donnez.

Le context engineering dans le RAG, c’est orchestrer tout ça intelligemment pour que le modèle ait exactement ce dont il a besoin, ni plus, ni moins.

Quelques outils intéressants

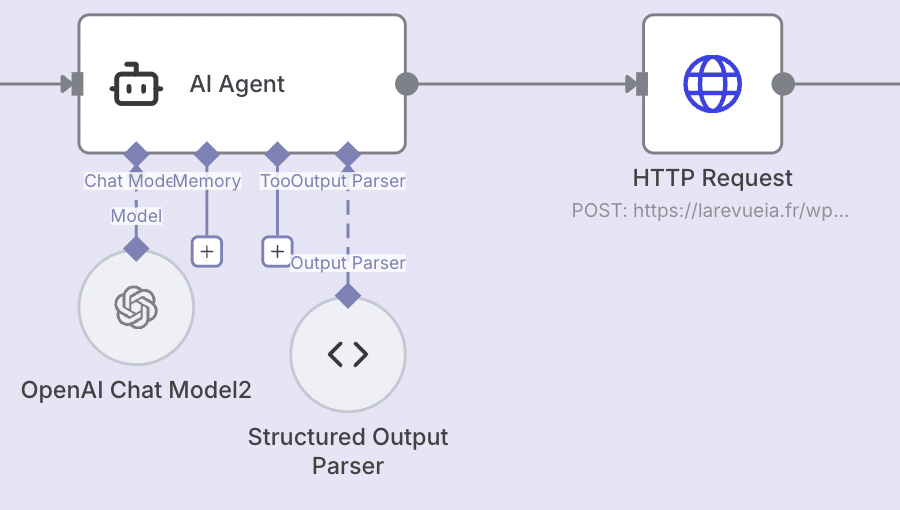

LangChain est devenu le couteau suisse du context engineering. Ses abstractions Memory gèrent différents types de contexte (conversation, faits, procédures), et ses retrievers offrent des stratégies avancées de récupération d’info. Parfait pour orchestrer des pipelines complexes.

LlamaIndex (ex-GPT Index) excelle dans la construction d’index et la navigation dans des corpus documentaires. Ses index hiérarchiques permettent d’aller du général au spécifique progressivement, ce qui est super pour gérer de gros volumes de docs.

Pour le stockage et la recherche d’embeddings, vous avez le choix : Weaviate (features avancées), Qdrant (performances), ou Chroma DB (simplicité, parfait pour débuter). Tous permettent de faire de la recherche sémantique sur des millions de vecteurs en quelques millisecondes.

Haystack et Semantic Kernel proposent des approches plus intégrées avec des pipelines pré-construits. Pratique si vous voulez démarrer vite, mais moins flexible que de composer vos propres solutions.

De mon côté j’ai co-fondé Akyn. On permet aux concepteurs d’agents IA d’intégrer des bases de connaissances facilement, via des serveurs MCP, tout en permettant aux experts métiers et créateurs de contenu de les monétiser.

En pratique

Le context engineering ne remplace pas le prompt engineering, il le complète. Vous avez toujours besoin de bons prompts pour guider le comportement du modèle. Mais maintenant, vous devez aussi penser à comment gérer l’information sur la durée.

Quelques principes à garder en tête : ne gardez que l’info pertinente dans le contexte, structurez-la clairement, et actualisez-la au fur et à mesure. Testez différentes stratégies de chunking et de retrieval pour votre use case spécifique. Et surtout, mesurez l’impact : le context engineering se valide par les résultats, pas par l’élégance théorique.

Les agents deviennent plus complexes, les applications plus ambitieuses. Le context engineering n’est plus optionnel, c’est une compétence fondamentale. Les outils sont là, les patterns émergent. À vous de jouer.

Laisser un commentaire