En mars 2023, lors d’une présentation live devenue culte menée par Greg Brockman, OpenAI dévoilait GPT-4. À l’époque, cette annonce avait mis en émoi la communauté tech, promettant des applications révolutionnaires.

Si cette annonce avait totalement éclipsé les tentatives de « teasing » de Google Workspace à l’époque, nous savons désormais que c’était le coup d’envoi d’une « guerre des IA » qui ne fait que s’intensifier aujourd’hui avec la montée en puissance de Google (Gemini), d’Anthropic (Claude) et de Meta (Llama). En plus des acteurs chinois qui s’imposent de plus en plus.

OpenAI avait passé deux ans à développer ce modèle pour offrir un outil polyvalent. Mais avec le recul, qu’est-ce qui différenciait vraiment GPT-4 de ses prédécesseurs, et ces promesses ont-elles tenu la route face aux versions plus récentes comme GPT-4o ou les modèles « o1 » ?

Retour sur les capacités fondatrices de ce modèle.

ChatGPT vs GPT-4

Petit rappel nécessaire : bien que ChatGPT ait été initialement propulsé par GPT-3.5, il ne s’agit que de l’interface (le chat). Le « moteur » sous le capot a évolué. Aujourd’hui, ChatGPT permet de jongler entre plusieurs versions de GPT-5 et GPT-4o.

Examinons les 5 piliers qui ont marqué le saut technologique de GPT-4 lors de sa sortie :

1. Une logique et un esprit de raisonnement renforcé

Lors du livestream historique, les démonstrations avaient mis en évidence la capacité de GPT-4 à exécuter des tâches complexes avec des contraintes difficiles (comme générer des résumés où chaque mot commence par une lettre spécifique).

Ce qui reste vrai aujourd’hui :

- Synthèse d’idées : La capacité du modèle à combiner des idées entre différents articles reste une référence.

- Calcul et Fiscalité : L’exemple du calcul d’impôts pour un couple, basé sur des documents administratifs denses, avait prouvé que l’IA pouvait naviguer dans la complexité législative (même si elle ne remplace toujours pas un fiscaliste certifié !).

Ce qui a changé : Si GPT-4 était impressionnant en raisonnement, les nouveaux modèles comme OpenAI o1 ou GPT-5 poussent cette logique encore plus loin en « réfléchissant » avant de répondre, excellant particulièrement en mathématiques et en code complexe.

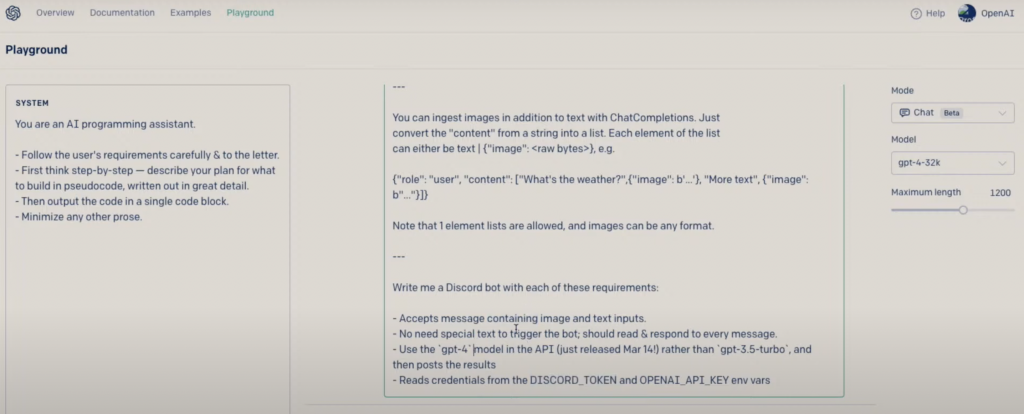

2. capacité d’ingérer du contenu existant pour se mettre à jour

Greg Brockman avait montré comment créer un bot Discord en fournissant à GPT-4 la documentation technique mise à jour (postérieure à sa date d’entraînement de 2021). Le modèle avait réussi à identifier les changements dans l’API et à corriger le code.

C’est aujourd’hui une norme via deux mécanismes :

- Le RAG (Retrieval-Augmented Generation) : La capacité des modèles à aller chercher l’info manquante dans vos propres bases de données ou sur le web.

- Les fenêtres de contexte immenses : On peut désormais copier-coller des livres entiers de documentation.

3. “Multimodal AI is here”, GPT-4 peut voir et comprendre des images en input:

C’était le changement le plus notable : GPT-4 est devenu « multimodal ». Il ne se contente plus de lire, il voit.

Le cas d’utilisation iconique de la présentation :

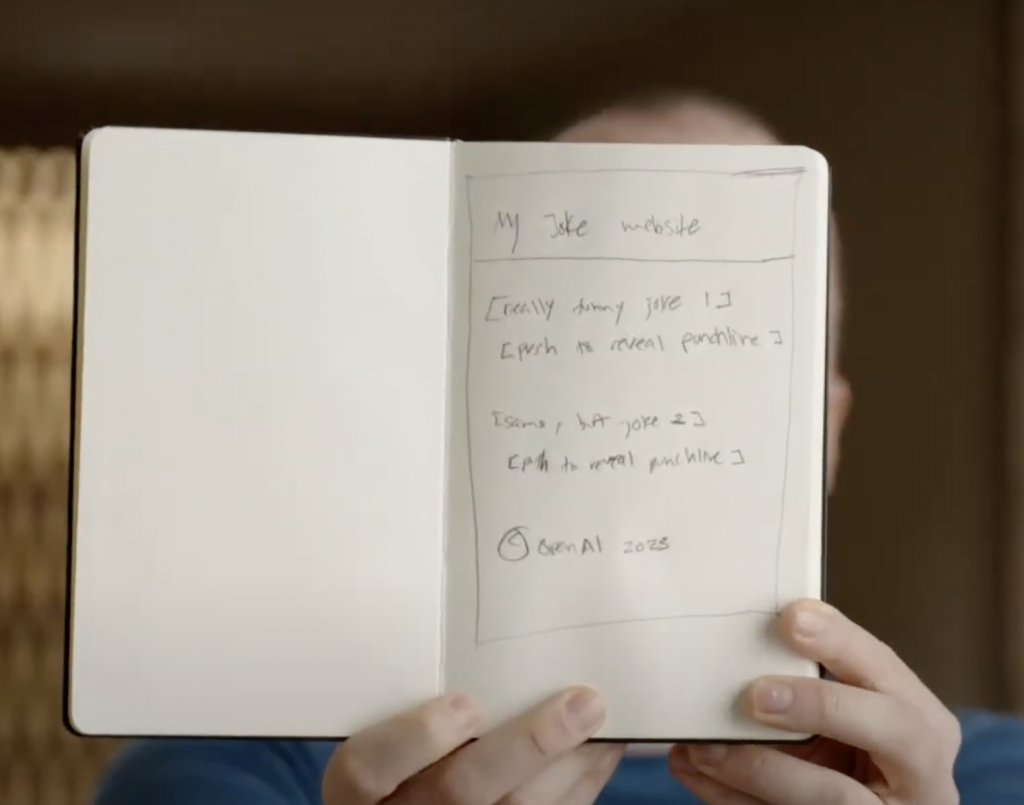

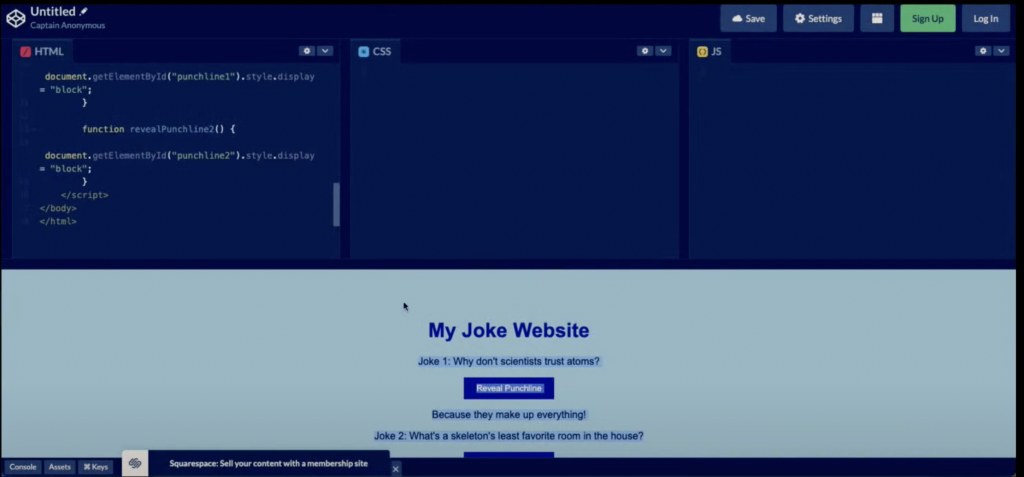

Greg Brockman dessine un schéma de site web sur un carnet (une blague griffonnée). Il prend une photo, l’envoie à GPT-4, et l’IA génère instantanément le code HTML/JavaScript fonctionnel correspondant.

Aujourd’hui, cette fonctionnalité n’est plus en « preview ». Depuis GPT-4o (« o » pour omni), la multimodalité est native : le modèle traite le texte, l’audio et l’image en temps réel avec une fluidité déconcertante, rendant les démos de 2023 presque lentes en comparaison.

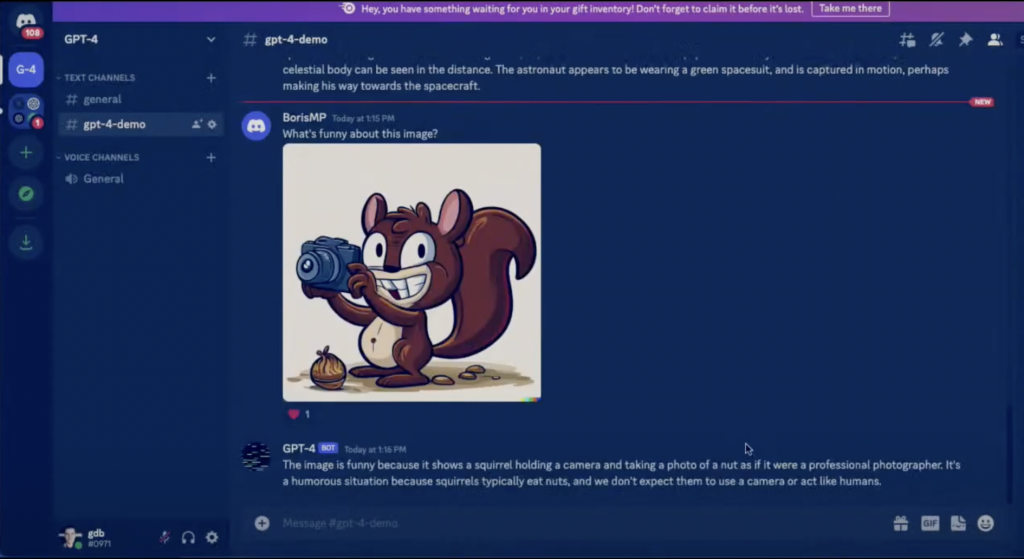

Dans le live on pouvait voir les capacités de reconnaissance d’images de GPT-4. Le modèle avait été utilisé pour décrire et dire pourquoi une image en particulier était drôle :

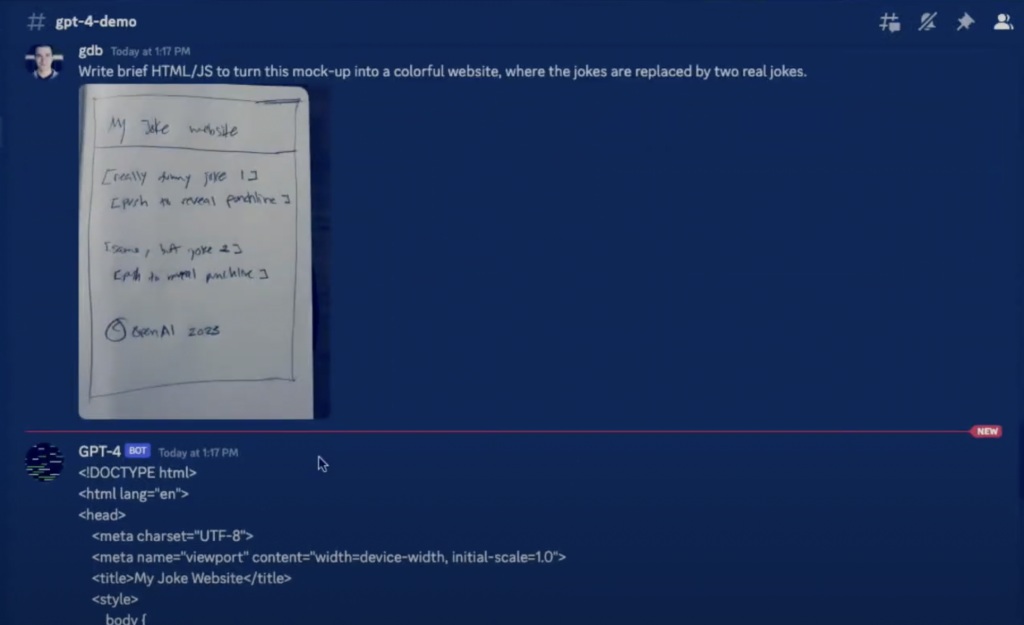

Le cas d’utilisation créative de GPT-4 qui nous avait le plus particulièrement marqué: le modèle avait été chargé de générer le code HTML d’une maquette dessinée à la main d’un site web de blagues.

voila à quoi ressemble le schéma:

D’une image à du code HTML/JS…

L’IA avait réussi à transformer la maquette en un code HTML fonctionnel et compatible avec JavaScript.

Ce segment avait mis en évidence la flexibilité de GPT-4, son impressionnante compréhension linguistique et visuelle, montrant qu’il peut être un outil puissant pour les développeurs dans le cadre de diverses tâches et applications.

A l’époque de Claude Code, Cursor ou Antigravity, ça ne nous impressionne plus tellement.

4. GPT-4 a une mémoire plus longue :

Les premiers modèles (GPT-3.5) « oubliaient » le début de la conversation après environ 4 à 5 pages de texte (4 096 tokens). GPT-4 a introduit une fenêtre de contexte de 32 768 tokens (environ 50 pages). Cela permettait de garder en mémoire une pièce de théâtre entière ou de longs documents techniques.

Mise à jour : Si 32k tokens semblaient énormes en 2023, la course s’est accélérée.

- GPT-4 Turbo avait introduit une montée à 128k tokens (300 pages).

- Google Gemini propose désormais des fenêtres de plus d’un million de tokens, capable d’ingérer des heures de vidéo ou des milliers de lignes de code.

Comment fonctionne GPT-4

Les détails techniques restent opaques, mais le principe reste la prédiction du mot suivant (Transformers), affinée par le RLHF (Reinforcement Learning from Human Feedback). C’est cette étape humaine qui permet de « polir » les réponses pour qu’elles soient utiles et sécurisées.

Cependant, la loi du « toujours plus grand » (plus de données, plus de paramètres) commence à montrer ses limites. La tendance actuelle se divise en deux :

- Des modèles massifs pour la performance pure.

- Des « Small Language Models » (SLM) plus frugaux et efficaces, capables de tourner en local sur des appareils.

Toujours plus de données, toujours plus de paramètres

GPT-4 prouvait, au moment de son lancement, une tendance qui se dessine depuis 2017 : on ne fait plus de vraies innovations sur les aspects techniques. Sur les sujets de traitements du langage notamment.

Les transformers ont une architecture qui permet de scaler, on se content donc d’agrandir la quantité de données et d’ajouter toujours plus de paramètres.

OpenAI a un avantage qui sera difficile à rattraper, à part peut être pour les mastodontes américains et chinois : ils ont commencé avant tout le monde.

Quelles sont les limites ?

Bien que GPT-4 soit un outil puissant, les limites identifiées lors de son lancement persistent, bien qu’atténuées :

- Les erreurs de raisonnement et les inventions de faits sont des problèmes persistants qui peuvent compromettre la fiabilité des sorties de modèle de langage, en particulier dans des contextes à haut risque. D’autant plus que, comme ça a toujours été le cas dans ChatGPT, GPT-4 donne les informations de façons très claires et en étant sur de lui.

- De même, GPT-4 ne dispose pas d’une connaissance complète des événements qui ont eu lieu après septembre 2021, et il n’est pas capable de se ré-entraîner en continu. Même si ce problème de cut-off (date de fin d’entraînement) est désormais contourné par la navigation web intégrée, permettant aux modèles de langage d’accéder à l’actualité en temps réel.

- Il fait parfois des erreurs de raisonnement simples et est trop crédule en acceptant des informations évidemment fausses données par l’utilisateur. Ce problème aussi a été atténué dans les versions récentes des LLM (GPT-5, Kimi K2, etc.)

Les garde-fous (safety) sont toujours plus présents, ce qui sécurise l’usage en entreprise mais peut brider la créativité ou l’analyse sur des sujets sensibles.

C’était ce qui avait poussé Elon Musk a lancer ses propres recherches avec son entreprise Grok.

Conclusion

L’IA générative a gagné en maturité depuis la sortie de GPT-4. Si OpenAI avait frappé un grand coup marketing et technique avec GPT-4, le monopole n’est plus aussi évident.

- Google s’est relevé avec la suite Gemini.

- Anthropic (créé par des anciens d’OpenAI) propose avec Claude 3.5 un modèle souvent jugé supérieur en codage et en nuance littéraire.

- Meta joue la carte de l’Open Source avec Llama, rebattant les cartes de l’accessibilité.

La question n’est plus « qu’est-ce que l’IA peut faire ? », mais « comment allons-nous travailler avec elle au quotidien ? ».

Laisser un commentaire