Dans l’arène technologique contemporaine, une compétition effrénée se joue, un marathon où l’Intelligence Artificielle (IA) tient le rôle de la médaille d’or tant convoitée.

Mais dans cette course, ce n’est pas tant la vitesse qui importe, mais la puissance et l’endurance. Dans le domaine de l’IA, l’endurance se mesure en termes de capacités de calcul, et la puissance en termes de capacités de traitement de données.

Autrement dit, en termes de hardware.

C’est ce que nous allons explorer aujourd’hui.

Bien loin des projecteurs, dans l’ombre des algorithmes et des ensembles de données, le matériel informatique joue un rôle déterminant dans la progression de l’IA.

Data centers titanesques et puces graphiques de pointe constituent les rouages essentiels de cette machine complexe.

Les progrès réalisés en IA ces dernières années ne sont pas uniquement dus à des modèles plus intelligents, mais à des modèles contenant toujours plus de paramètres entraînables et entraînés sur des volumes de données sans cesse croissants.

Alors, attachez vos ceintures et préparez-vous pour un voyage à travers les coulisses de la course à l’IA, où nous découvrirons que dans ce marathon technologique, le hardware est bien plus qu’un simple accessoire : il est le cœur même de la machine.

L’importance des data centers

A quoi sert un data center ?

Imaginez un orchestre, où chaque instrument joue un rôle crucial pour créer une harmonie parfaite. Dans l’univers de l’Intelligence Artificielle, les data centers sont le chef d’orchestre.

Les data centers, ou centres de données, sont des infrastructures dédiées où sont rassemblés des équipements de traitement et de stockage de données. Ces véritables cerveaux numériques sont essentiels pour gérer, traiter et distribuer d’énormes volumes de données, et donc, pour la mise en œuvre de l’IA.

Ces centres de données ne sont pas simplement des entrepôts remplis de serveurs, mais des écosystèmes technologiques complexes, où chaque composant, du serveur à la puce, du routeur au système de refroidissement, joue un rôle dans la gestion efficace des données.

Sans ces architectures sophistiquées, le traitement des grands volumes de données nécessaires à l’entraînement des modèles d’IA serait une tâche herculéenne, voire impossible.

Un meilleur hardware dans les data centers permet d’améliorer notre façon de faire de l’IA

Mais ce n’est pas tout. Les data centers sont en constante évolution. Au fur et à mesure que l’IA progresse, la demande en capacité de calcul augmente, et les data centers doivent s’adapter.

Les améliorations du hardware dans les data centers, qu’il s’agisse de serveurs plus puissants, de mémoires plus rapides ou de systèmes de refroidissement plus efficaces, ont été des facteurs clés de l’évolution de l’IA.

En somme, le rôle des data centers dans le domaine de l’IA est comparable à celui du chef d’orchestre dans un orchestre : sans lui, chaque instrument pourrait être performant, mais l’harmonie serait absente. Il n’y a pas de symphonie sans chef, et il n’y a pas d’IA sans data centers.

C’est ici que la vraie magie de l’IA prend vie, où les données sont transformées en informations, où les bits deviennent de la connaissance. Les data centers sont le cœur palpitant de l’IA, orchestrant le rythme auquel avance cette révolution technologique.

Le rôle crucial des GPUs

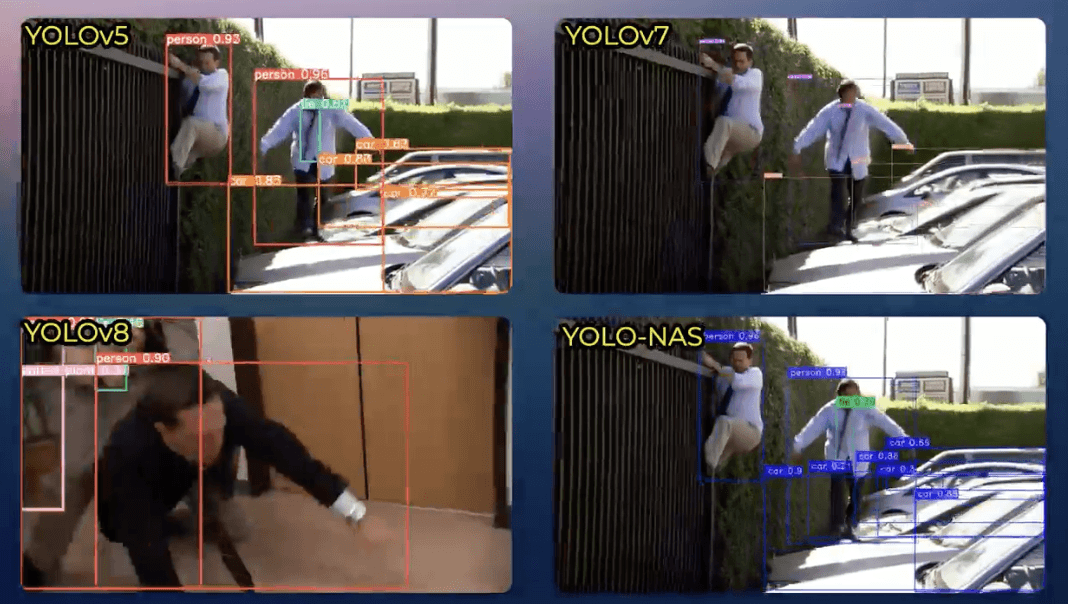

Dans l’orchestre des data centers, si le chef d’orchestre est la structure organisatrice, alors les GPUs, ou unités de traitement graphique, sont les violons solistes, les véritables stars du spectacle. Sans ces GPUs, l’entraînement des modèles de deep learning, une sous-catégorie de l’IA, serait tout simplement impensable.

Les GPUs, initialement conçus pour le rendu graphique dans les jeux vidéo, se sont avérés exceptionnellement efficaces pour le calcul parallèle – la capacité d’exécuter plusieurs calculs simultanément. Cette caractéristique s’est révélée être une aubaine pour le deep learning, qui nécessite des opérations matricielles massives, une tâche pour laquelle les GPUs sont parfaitement adaptés.

Les GPUs sont donc devenus une pierre angulaire de l’entraînement des modèles d’IA. Ils permettent de traiter rapidement des volumes énormes de données, d’accélérer les temps d’entraînement et d’optimiser les performances des modèles. Sans eux, l’entraînement d’un seul modèle d’IA pourrait prendre des mois, voire des années.

Et comme les data centers, les GPUs ont également évolué. Les constructeurs, conscients de leur importance croissante dans le domaine de l’IA, ont développé des GPUs de plus en plus puissants, capables de traiter des volumes de données toujours plus importants et de soutenir des modèles d’IA de plus en plus complexes.

Et aujourd’hui, les maestros du monde des GPUs pour le deep learning, sont incontestablement, Nvidia.

En fin de compte, l’impact des GPUs sur l’efficacité et la vitesse de l’IA est incontestable. Ils sont les violons solistes de notre orchestre, jouant la mélodie du deep learning avec une virtuosité sans précédent. Sans les GPUs, le concert de l’IA ne serait qu’un murmure. Avec eux, il devient une symphonie.

Toujours plus de paramètres, toujours plus de data

Reprenons notre analogie musicale. Si les data centers sont le chef d’orchestre et les GPUs les violons solistes, alors les modèles d’IA sont la partition musicale. C’est à travers eux que la symphonie de l’IA prend forme. Cependant, ces partitions sont devenues de plus en plus complexes au fil du temps, gagnant en longueur et en détails.

Au cours des dernières années, une tendance claire s’est dégagée dans le développement des modèles d’IA : une augmentation constante du nombre de paramètres et une soif insatiable de données. Ces modèles gigantesques, tels que GPT-3 de OpenAI avec ses 175 milliards de paramètres, GPT-4 en a potentiellement des dizaines de trillions, semblent suivre la loi de Moore de l’IA, doublant (ou faisant x100) en taille tous les 16 mois environ. Cette croissance exponentielle a été rendue possible grâce aux améliorations constantes du hardware.

Cependant, cette course au gigantisme soulève des questions d’ordre économique. Les entreprises qui possèdent les moyens de calcul nécessaires pour entraîner ces monstres de puissance ont un avantage compétitif considérable. On peut craindre une concentration de pouvoir entre les mains de quelques géants technologiques, avec le risque de créer des monopoles dans le domaine de l’IA.

Par ailleurs, cette tendance à la croissance n’est pas sans susciter des divergences stratégiques au sein de la communauté de l’IA.

D’un côté, il y a ceux qui poussent à l’augmentation de la taille des modèles, convaincus que la route vers l’IA généralisée passe par toujours plus de données et de paramètres. De l’autre, il y a des voix dissidentes, comme celle de Yann LeCun, lauréat du prix Turing et pionnier du deep learning, qui plaide pour une approche plus frugale. LeCun propose de se tourner vers des modes d’apprentissage plus intelligents, tels que le self-supervised learning. Il souligne que contrairement à une machine, un enfant n’a pas besoin de voir des milliers d’images d’une girafe pour comprendre le concept de girafe.

Quelle que soit la voie que nous choisissons de suivre, une chose est certaine : le rôle du hardware restera central. Qu’il s’agisse de soutenir la croissance exponentielle des modèles ou de rendre possible des approches d’apprentissage plus sophistiquées, le hardware est et restera le chef d’orchestre de la symphonie de l’IA.

Conclusion

En conclusion, l’importance du hardware dans la course à l’IA est indéniable. Comme nous l’avons vu, les data centers sont le chef d’orchestre qui régit l’orchestre de l’IA, tandis que les GPUs sont les virtuoses solistes qui jouent la mélodie du deep learning. Quant aux modèles d’IA, ils sont la partition complexe et toujours plus longue sur laquelle se joue la symphonie de l’IA.

Cependant, il est important de souligner que cette course technologique n’est pas sans conséquences. L’un des enjeux les plus pressants est l’impact environnemental de cette augmentation constante de la puissance de calcul. Les data centers consomment une quantité d’énergie colossale, et leur empreinte carbone est loin d’être négligeable. Il est donc essentiel de prendre en compte cet aspect dans notre quête de l’IA.

Finalement, que nous choisissions de suivre la voie de la croissance exponentielle des modèles ou celle de l’apprentissage plus frugal, une chose est certaine : le hardware sera toujours au cœur de l’IA. Alors que nous continuons à explorer les possibilités offertes par l’IA, n’oublions pas l’importance de l’infrastructure qui la rend possible. Après tout, dans la course à l’IA, le hardware n’est pas seulement un accessoire : c’est le véritable cœur de la machine.

Leave a Comment